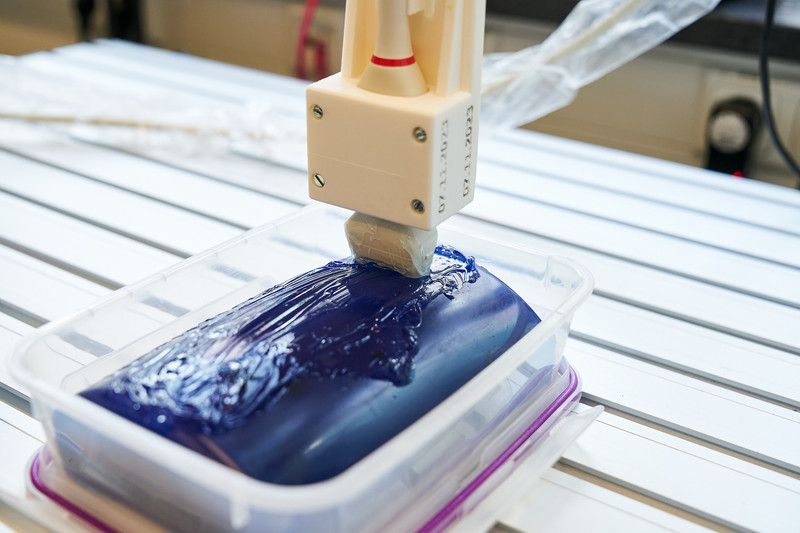

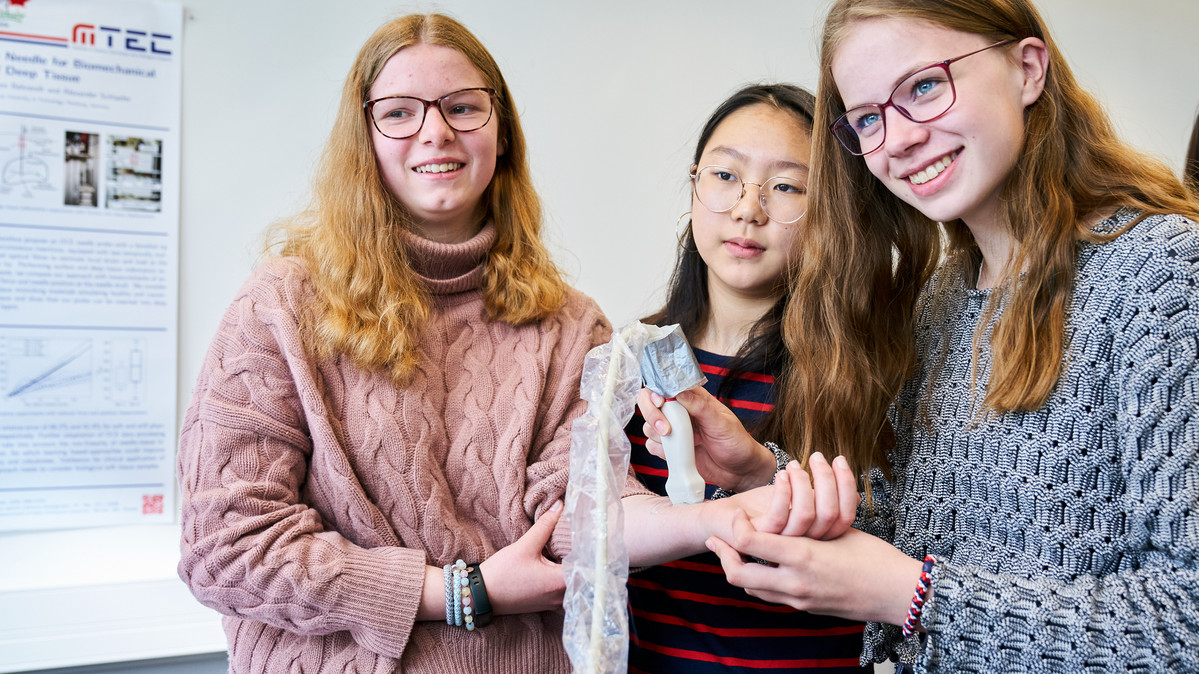

Der blau gefärbte Patient zuckt und zappelt nicht, er macht keinen Pips, als Bianca auf seiner Oberfläche mit der Sonde Glibber Gel verteilt und von einem Ende zum anderen zieht. Voll konzentriert und sachte geht die Lise-Meitner-Schülerin vor, obwohl sie kein Lebewesen, sondern ein „Ultraschall-Phantom“, ein Trainingsgerät für Ärzte scannt. Es ist weich und wabbelig – das steht für die menschliche Haut. Es enthält Schläuche – das steht für Venen oder Arterien. Und genau um solche unter der Haut verborgenen Gefäße geht es: Ein modernes Ultraschallsystem soll aus vielen Einzelbildern ein dreidimensionales Volumenbild erstellen. Das erfordert viel Rechenleistung – und eine ruhige Hand. „Langsam, ganz langsam“, mahnt Johanna Sprenger. Die Doktorandin im Institut für Medizintechnische und Intelligente Systeme (MTEC) an der TUHH führt an diesem Vormittag mint:pink-Teilnehmerinnen in die Medizintechnik von morgen ein.

Unter die Haut gehen – in 3D

Erste Lektion: Robotergestützte Systeme sind aus der modernen Krebsbehandlung und Chirurgie nicht mehr wegzudenken. Das machen die vielen Beispiele deutlich, die Johanna und ihr Kollege Konrad Reuter in ihrer Einführungspräsentation vorstellen. Zweite Lektion: Am MTEC gibt es Labore ohne Kittel und Kolben. Man kann eben auch mit Robotern, Kraftsensor und Programmiersprachen experimentieren. „Wenn man in 3D weiß, wie es unter der Haut des Patienten aussieht, kann man das Ultraschallbild in eine Augmented Reality Brille überlagern“, erklärt Doktorandin Sprenger die Grundidee. Bis die AR-Medizin an der Tagesordnung ist, dauert es noch ein wenig. Im Institut wird an verschiedenen Projekten geforscht, um beispielsweise mit Robotern und Deep Learning die Ärzte zu unterstützen, so die Medizintechnikerin.

Hand in Hand – Maschine und Mensch

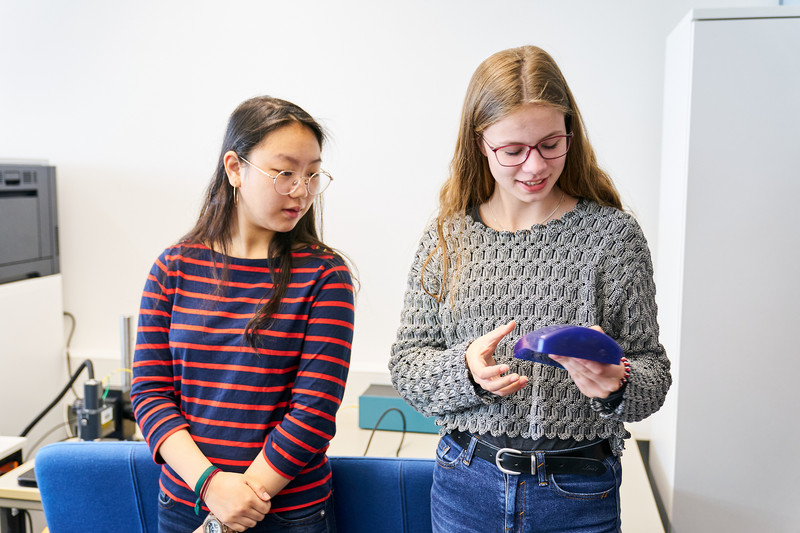

Ultraschall liefert Bilder in Echtzeit, schnell und unschädlich – und ist daher in der Medizin gefragt. Aber in einer Hand die Nadel, in der anderen den Ultraschallsensor – und den Blick gleichzeitig auf Patient und Bildschirm gerichtet, das ist schon recht komplex. Daher wird Biancas Scan von Hand in einem zweiten Durchlauf vom Roboter ausgeführt. Sein Arm mit der Sonde tastet sich zur Oberfläche vor, schiebt das Gel geradlinig über das Phantom und nimmt dabei in kurzer Zeit über tausend Bilder auf. Sie werden von der Software automatisch zu einer Gesamtansicht der inneren Gefäße verarbeitet. Nur lag das Testphantom nicht ganz gerade, weshalb der Roboter ein wenig dran vorbei gearbeitet hat. „In deinem Fall sieht es besser aus, weil wir das sehen, was wir sehen wollen“, lobt Johanna Biancas Arbeit. Applaus für die Schülerin.

Das Wissen von x Medizinern – in einem neuronalen Netz

Ultraschall ist cool, aber den größten Applaus verdienen eigentlich die Berechnungen, findet Anna. „Wie viel Druck wird ausgeübt, wie werden die Bilder ausgewertet und gefiltert – alles basiert auf Rechnungen und das fasziniert mich“, sagt die 15-Jährige. Das ist vor allem faszinierend effizient: Statt mehrerer Mediziner, die in mühevoller Kleinarbeit in Tausenden von Bildern Gefäße markieren, übernimmt ein neuronales Netz, das mit all diesen Informationen trainiert wurde. „Das Netz ist im besten Fall so gut wie die Ärzte zusammen“, so Johanna Sprenger. Legt man dann noch einen Filter über das Volumen, sind die Strukturen noch besser erkennbar, demonstriert die Forscherin. Ein echter Aha-Effekt für Annas Freundin Feli. „Ich habe beim theoretischen Vortrag noch gar nicht verstanden, wozu man Bilder überhaupt filtert – ist doch am besten, wenn man sie so genau wie möglich hat.“ Erst die Theorie, dann die Praxis sei ein gutes Konzept, so Feli. „Das war sehr anschaulich.“